O companie noua lucreaza la cel mai avansat cip AI pentru modele LLM din lume. Acel cip are 10 trilioane (10 mii de miliarde) de tranzistori, lucru de care n-au fost capabile companii mai mari si mai vechi.

In ultimii ani, NVIDIA a avut un mare succes cu accentul sau pe AI, avand in vedere ca modelele de limbaj (LLM) si experientele „premium AI PC” accelerate de GPU par sa fie noul lucru important in 2024.

Cu toate acestea, companii mai noi si mai mici doresc o parte din acea cota de piata, dar acele companii nu sunt cele la care v-ati putea astepta.

Conform The Economist, au existat evolutii in domeniul GPU in afara celor mai bune placi grafice construite de NVIDIA si AMD pentru calcul AI. Asta pentru ca unele modele LLM din ziua de azi ruleaza pe multe sisteme care au placi grafice si memorie interconectate, cum ar fi hardware-ul companiei Cerebras.

Compania Cerebras Systems Inc. a fost fondata acum doar 9 ani in urma, dar pare ca aceasta beneficiaza in mod masiv de recentul boom al calcului AI. Sistemul Cerebras pare sa depaseasca actuala generatie H100 si GB200 cu „un singur cip enorm” cu pana la 900.000 de nuclee GPU, cipul sau CS-3.

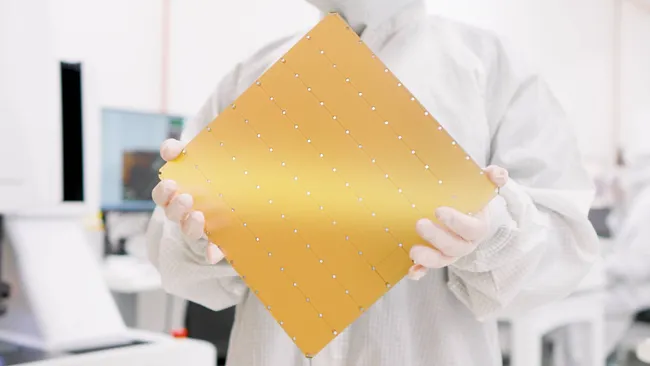

Cipul Cerebras CS-3 e de doua ori mai mare decat cipul GB200 urias si e de dimensiunea unui volan, ceea ce necesita doua maini pentru a fi tinut. E descris de producator ca fiind „cel mai rapid si scalabil accelerator AI din lume” si a fost construit pentru a „antrena cele mai avansate modele AI din lume”.

Mai mult, producatorul american a declarat ca acesta e „cipul care a incalcat legea lui Moore”. Dupa cum arata testele benchmark, CS-3 are un numar total de tranzistori de 10.000.000.000.000, ceea ce e o crestere de 4707% fata de numarul de tranzistori inclusi in GB200.

TechRadar